Khi nhu cầu sử dụng các mô hình ngôn ngữ lớn linh hoạt, tiết kiệm chi phí và đảm bảo quyền riêng tư ngày càng tăng, Ollama AI nổi lên như một giải pháp mã nguồn mở đột phá, cho phép người dùng chạy các mô hình AI tiên tiến ngay trên máy tính cá nhân. Vậy cụ thể Ollama AI là gì? Nền tảng này có gì đặc biệt? Cùng Tino tìm hiểu qua bài viết dưới đây nhé!

Ollama là một nền tảng mã nguồn mở đột phá, được thiết kế để đơn giản hóa quá trình triển khai và quản lý các mô hình ngôn ngữ lớn (LLM) trực tiếp trên máy tính cá nhân của bạn. Thay vì phải phụ thuộc vào các dịch vụ đám mây tốn kém và tiềm ẩn rủi ro bảo mật dữ liệu, Ollama cho phép bạn chạy các mô hình AI mạnh mẽ như Llama 2, Mistral, Gemma và nhiều mô hình khác ngay trên phần cứng của mình. Điều này không chỉ giúp tiết kiệm chi phí mà còn tăng cường quyền riêng tư và kiểm soát dữ liệu.

Nền tảng này được ra mắt vào năm 2023 bởi hai nhà sáng lập tài năng là Jeffrey Morgan và Michael Chiang. Với tầm nhìn chung là dân chủ hóa quyền truy cập vào công nghệ AI tiên tiến, họ đã tạo ra Ollama với mục tiêu làm cho các công cụ AI trở nên dễ tiếp cận hơn cho mọi người, từ các nhà phát triển cá nhân, nhà nghiên cứu đến các doanh nghiệp nhỏ. Kể từ khi ra mắt, Ollama đã nhanh chóng thu hút một cộng đồng người dùng và nhà phát triển lớn mạnh, liên tục đóng góp và cải tiến nền tảng này, biến nó thành một trong những công cụ hàng đầu cho việc triển khai LLM cục bộ.

Sự đặc biệt của Ollama AI không chỉ nằm ở khả năng chạy LLM cục bộ mà còn ở cách nó giải quyết các thách thức lớn trong việc triển khai và quản lý AI.

Trước Ollama, việc thiết lập một môi trường để chạy các mô hình ngôn ngữ lớn cục bộ thường đòi hỏi kiến thức sâu rộng về cấu hình phần cứng, quản lý thư viện, và giải quyết các vấn đề tương thích. Ollama đã đơn giản hóa toàn bộ quy trình này bằng cách cung cấp một gói cài đặt duy nhất, tự động hóa việc tải xuống các mô hình, quản lý các phụ thuộc và tối ưu hóa hiệu suất. Điều này giúp người dùng, kể cả những người không chuyên về AI, có thể dễ dàng bắt đầu sử dụng LLM chỉ với vài dòng lệnh đơn giản.

Ollama được thiết kế để tận dụng tối đa sức mạnh của phần cứng cục bộ, đặc biệt là GPU. Nền tảng tự động tối ưu hóa việc sử dụng VRAM và tài nguyên tính toán, đảm bảo các mô hình chạy mượt mà và hiệu quả nhất có thể. Điều này đặc biệt quan trọng đối với các mô hình LLM lớn, vốn đòi hỏi lượng tài nguyên đáng kể. Khả năng tối ưu hóa này giúp người dùng khai thác tối đa hiệu suất từ máy tính của mình mà không cần phải là chuyên gia về tối ưu hóa phần cứng.

Một trong những lợi ích lớn nhất của việc chạy LLM cục bộ với Ollama là khả năng kiểm soát hoàn toàn dữ liệu. Khi các mô hình chạy trên máy tính của bạn, dữ liệu đầu vào và đầu ra không cần phải gửi lên các máy chủ đám mây bên ngoài. Điều này loại bỏ các lo ngại về quyền riêng tư và bảo mật dữ liệu, đặc biệt quan trọng đối với các ứng dụng xử lý thông tin nhạy cảm hoặc trong các môi trường doanh nghiệp yêu cầu tuân thủ quy định nghiêm ngặt.

Một trong những lợi ích lớn nhất của việc chạy LLM cục bộ với Ollama là khả năng kiểm soát hoàn toàn dữ liệu. Khi các mô hình chạy trên máy tính của bạn, dữ liệu đầu vào và đầu ra không cần phải gửi lên các máy chủ đám mây bên ngoài. Điều này loại bỏ các lo ngại về quyền riêng tư và bảo mật dữ liệu, đặc biệt quan trọng đối với các ứng dụng xử lý thông tin nhạy cảm hoặc trong các môi trường doanh nghiệp yêu cầu tuân thủ quy định nghiêm ngặt.

Ollama không chỉ hỗ trợ một loạt các mô hình LLM có sẵn mà còn cho phép người dùng tạo và tùy chỉnh các mô hình của riêng họ thông qua các tệp Modelfile. Điều này mở ra khả năng vô tận cho các nhà phát triển và nhà nghiên cứu để thử nghiệm, tinh chỉnh và triển khai các giải pháp AI độc đáo phù hợp với nhu cầu cụ thể của họ. Khả năng tích hợp với các ứng dụng khác thông qua API RESTful cũng làm tăng tính linh hoạt của Ollama, cho phép nó trở thành một phần của các hệ thống phức tạp hơn.

Là một dự án mã nguồn mở, Ollama được hưởng lợi từ sự đóng góp và hỗ trợ của một cộng đồng toàn cầu. Điều này không chỉ đảm bảo rằng Ollama luôn được cập nhật với các tính năng mới nhất và các bản vá lỗi mà còn tạo ra một môi trường hợp tác, nơi người dùng có thể chia sẻ kiến thức, giải quyết vấn đề và cùng nhau phát triển. Sự minh bạch và tính mở của mã nguồn cũng góp phần xây dựng niềm tin và thúc đẩy sự đổi mới.

Ollama được thiết kế để hoạt động mượt mà trên nhiều hệ điều hành phổ biến, bao gồm macOS, Windows, và Linux. Ngoài ra, công cụ còn hỗ trợ triển khai trong môi trường Docker, mang lại sự linh hoạt tối đa cho các nhà phát triển và người dùng có nhu cầu triển khai trong các môi trường ảo hóa hoặc container.

Ollama liên tục cập nhật và mở rộng thư viện các mô hình ngôn ngữ lớn mà nó hỗ trợ, mang đến cho người dùng quyền truy cập vào những công nghệ AI tiên tiến nhất. Dưới đây là một trong số những mô hình nổi bật được Ollama hỗ trợ:

- DeepSeek-R1: Đây là một mô hình mạnh mẽ được thiết kế cho các tác vụ suy luận phức tạp và xử lý ngôn ngữ tự nhiên chuyên sâu. DeepSeek-R1 nổi bật với khả năng hiểu ngữ cảnh tốt và tạo ra các phản hồi mạch lạc, phù hợp cho các ứng dụng yêu cầu độ chính xác cao như phân tích văn bản pháp lý, nghiên cứu khoa học hoặc hỗ trợ ra quyết định.

- Qwen 3: Là phiên bản mới nhất của dòng mô hình Qwen, Qwen 3 được phát triển bởi Alibaba Cloud. Mô hình này được biết đến với hiệu suất vượt trội trong nhiều tác vụ NLP, bao gồm dịch thuật, tóm tắt và tạo nội dung sáng tạo.

- Llama 3.3: Là thế hệ tiếp theo của dòng mô hình Llama từ Meta AI, Llama 3.3 tiếp tục cải thiện về khả năng suy luận, hiểu biết thế giới và khả năng tuân thủ hướng dẫn. Với kiến trúc được tối ưu hóa, Llama 3.3 là một lựa chọn lý tưởng cho các ứng dụng chatbot, trợ lý ảo và các hệ thống tương tác ngôn ngữ tự nhiên yêu cầu phản hồi nhanh và chính xác.

- Gemma 3: Được phát triển bởi Google, Gemma 3 là một dòng mô hình nhẹ và hiệu quả, được xây dựng dựa trên công nghệ tiên tiến được sử dụng trong các mô hình Gemini. Gemma 3 được thiết kế để dễ dàng triển khai và tùy chỉnh, phù hợp cho các nhà phát triển muốn xây dựng các ứng dụng AI nhỏ gọn, nhanh chóng và có khả năng hoạt động trên các thiết bị có tài nguyên hạn chế.

- LLaVA: Đây là một mô hình đa phương thức khác nổi bật, kết hợp bộ mã hóa thị giác với mô hình ngôn ngữ để hiểu và tương tác với cả văn bản và hình ảnh. LLaVA đặc biệt hữu ích cho các tác vụ yêu cầu sự kết hợp giữa hiểu biết thị giác và ngôn ngữ, như phân tích tài liệu có hình ảnh, tạo chú thích tự động, hoặc hỗ trợ người dùng khiếm thị.

Các mô hình này, cùng với nhiều mô hình khác có sẵn trong thư viện của Ollama (ollama.com/library), được cập nhật liên tục, đảm bảo người dùng luôn có quyền truy cập vào những công nghệ AI mới nhất và phù hợp nhất với nhu cầu của mình.

Ollama là một công cụ mã nguồn mở và hoàn toàn miễn phí để tải xuống và sử dụng. Điều này mang lại lợi ích đáng kể cho người dùng, đặc biệt là trong bối cảnh chi phí sử dụng các dịch vụ AI dựa trên đám mây ngày càng tăng cao.

- Miễn phí sử dụng phần mềm: Bạn không phải trả bất kỳ khoản phí cấp phép hay đăng ký nào để sử dụng Ollama. Toàn bộ mã nguồn đều công khai, cho phép bạn tự do kiểm tra, sửa đổi và phân phối.

- Tiết kiệm chi phí API: Khi sử dụng các dịch vụ LLM thương mại như OpenAI GPT-3/4, Google Gemini hoặc Anthropic Claude, người dùng thường phải trả phí dựa trên số lượng token đầu vào và đầu ra (API calls). Với Ollama, các mô hình chạy cục bộ trên máy tính của bạn, loại bỏ hoàn toàn chi phí API này.

- Đầu tư phần cứng ban đầu: Mặc dù phần mềm Ollama miễn phí, nhưng để chạy các mô hình ngôn ngữ lớn một cách hiệu quả, bạn cần có phần cứng đủ mạnh. Cụ thể, một card đồ họa (GPU) với bộ nhớ VRAM (Video RAM) lớn là yếu tố quan trọng nhất. Các mô hình LLM lớn có thể yêu cầu từ vài GB đến hàng chục GB VRAM..

- Chi phí điện năng: Việc chạy các mô hình LLM cục bộ trên GPU có thể tiêu thụ một lượng điện năng đáng kể, đặc biệt là khi chạy liên tục trong thời gian dài. Đây là một chi phí vận hành nhỏ nhưng cần được tính đến, đặc biệt đối với các ứng dụng doanh nghiệp hoặc các dự án nghiên cứu chuyên sâu.

Nhìn chung, Ollama AI mang lại một giải pháp tiết kiệm chi phí đáng kể cho việc triển khai AI, đặc biệt là cho những ai muốn kiểm soát hoàn toàn dữ liệu và không muốn phụ thuộc vào các nhà cung cấp dịch vụ đám mây. Chi phí chính yếu là đầu tư ban đầu vào phần cứng, nhưng lợi ích về lâu dài về quyền riêng tư, bảo mật và khả năng tùy biến thường vượt xa khoản đầu tư này.

Mặc dù Ollama AI mang lại nhiều lợi ích đáng kể, đặc biệt là trong việc dân chủ hóa quyền truy cập vào các mô hình ngôn ngữ lớn, nhưng nó vẫn còn một số hạn chế cần được xem xét kỹ lưỡng trước khi triển khai, đặc biệt là trong các môi trường sản xuất hoặc yêu cầu cao:

Đây là hạn chế lớn nhất của Ollama. Để chạy các mô hình LLM lớn và phức tạp một cách hiệu quả, Ollama yêu cầu một card đồ họa (GPU) mạnh mẽ với dung lượng VRAM (Video RAM) đáng kể.

Mặc dù Ollama cho phép chạy các mô hình ngoại tuyến sau khi tải xuống, nhưng quá trình tải mô hình ban đầu vẫn yêu cầu kết nối internet ổn định và nhanh chóng. Các mô hình LLM thường có kích thước rất lớn (vài GB đến hàng chục GB), do đó, việc tải xuống có thể mất nhiều thời gian và tiêu tốn đáng kể băng thông mạng.

Là một công cụ mã nguồn mở và được thiết kế để chạy cục bộ, Ollama có thể tiềm ẩn các lỗ hổng bảo mật nếu không được cấu hình đúng cách hoặc nếu người dùng không cập nhật phiên bản mới nhất. Người dùng cần phải cẩn trọng trong việc triển khai Ollama trong môi trường mạng không an toàn hoặc tiếp xúc với internet.

Khi phát triển các ứng dụng tích hợp với Ollama, việc gỡ lỗi các phản hồi từ mô hình hoặc xử lý các lỗi phát sinh có thể phức tạp hơn so với việc sử dụng các nền tảng đám mây có tài liệu và công cụ gỡ lỗi phong phú.

Khi phát triển các ứng dụng tích hợp với Ollama, việc gỡ lỗi các phản hồi từ mô hình hoặc xử lý các lỗi phát sinh có thể phức tạp hơn so với việc sử dụng các nền tảng đám mây có tài liệu và công cụ gỡ lỗi phong phú.

Ollama được thiết kế chủ yếu cho việc chạy LLM trên một máy tính cá nhân hoặc một máy chủ đơn lẻ. Mặc dù có thể triển khai trên Docker hoặc Kubernetes, nhưng việc mở rộng quy mô để phục vụ hàng ngàn hoặc hàng triệu người dùng đồng thời có thể là một thách thức.

Để sử dụng các phiên bản mô hình mới nhất hoặc các mô hình mới được phát hành, người dùng cần phải tự mình cập nhật hoặc tải xuống thông qua Ollama CLI.

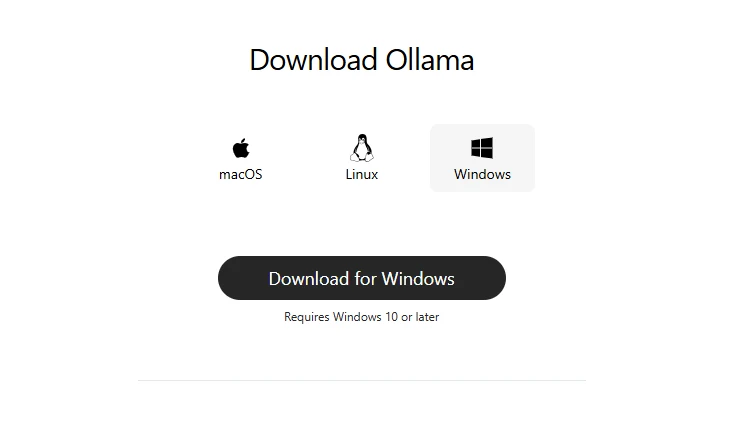

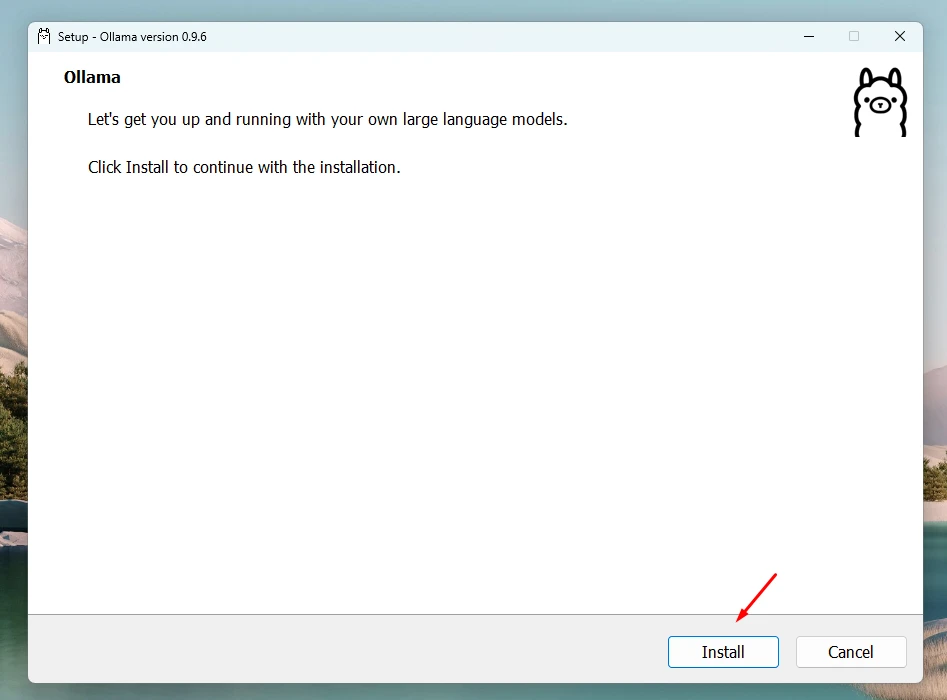

Bước 1: Mở trình duyệt web và truy cập vào trang web chính thức của Ollama tại ollama.com.

Bước 2: Trên trang chủ, bạn sẽ thấy các tùy chọn tải xuống cho các hệ điều hành khác nhau như macOS, Windows, Linux và Docker. Hãy chọn phiên bản phù hợp với hệ điều hành mà bạn đang sử dụng.

Sau khi cài đặt thành công, Ollama sẽ chạy ngầm trên hệ thống của bạn, sẵn sàng để bạn tương tác.

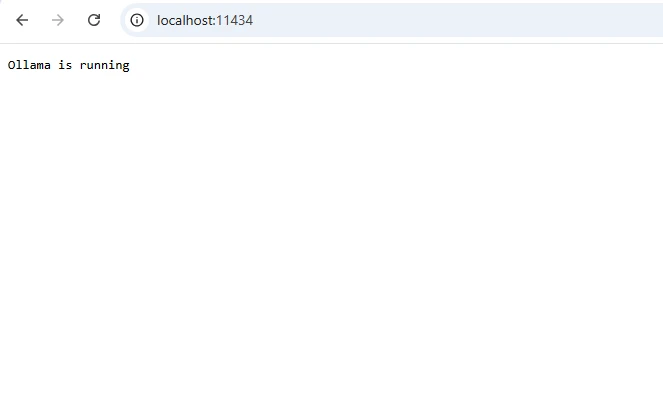

Mở trình duyệt và truy cập http://localhost:11434. Nếu hiện thông báo "Ollama is running" tức là đã cài đặt thành công.

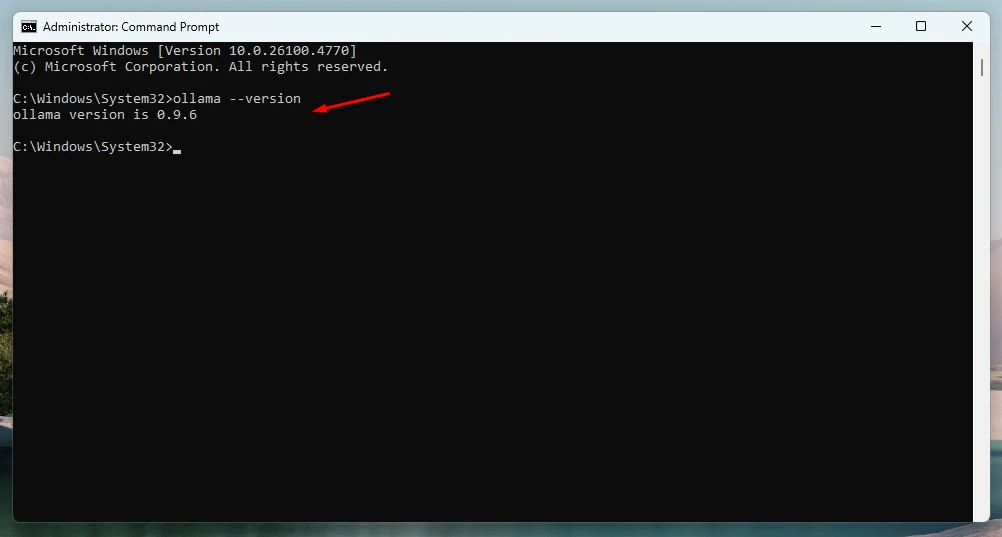

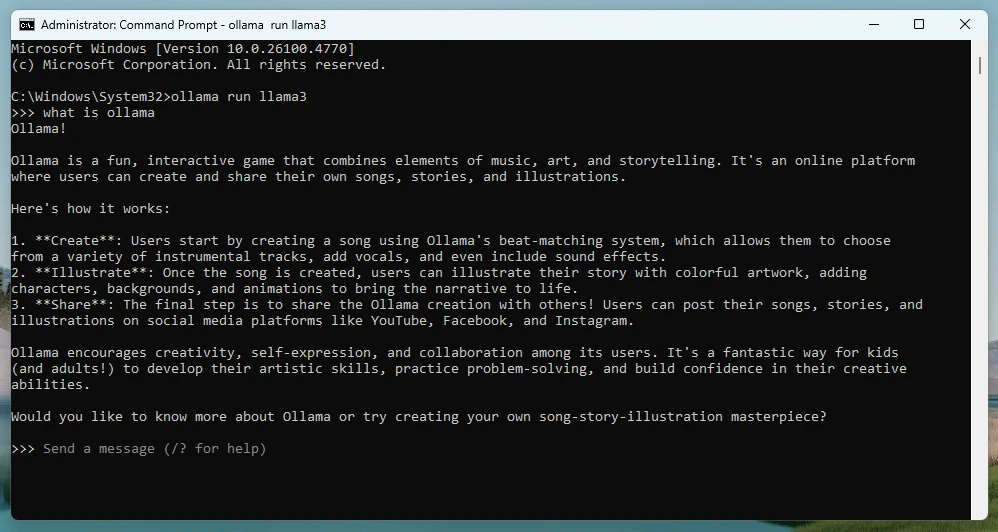

Bước 3: Ollama chủ yếu được điều khiển thông qua giao diện dòng lệnh (CLI). Bạn có thể mở terminal (hoặc Command Prompt (CMD)/PowerShell trên Windows) để bắt đầu.

Ví dụ: Tino sẽ cài đặt Ollama trên Windows, tại cửa sổ CMD, gõ lệnh sau để kiểm tra phiên bản:

ollama --version

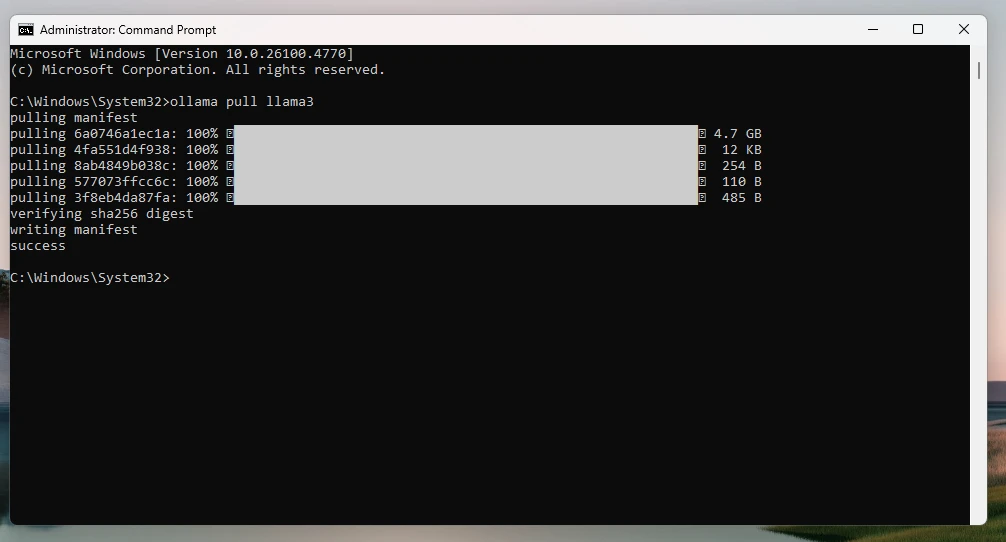

Tải một mô hình (ví dụ Llama 3):

ollama pull llama3

Chạy mô hình LLaMA 3:

ollama run llama3

Sau đó, bạn có thể bắt đầu gõ câu hỏi và trò chuyện với mô hình trực tiếp trong CMD. Bạn có thể nhập câu hỏi, yêu cầu bằng tiếng Việt hoặc tiếng Anh.

Kết thúc phiên chat:

Nhấn Ctrl+C.

Liệt kê các mô hình đã cài đặt:

ollama list

Một số lệnh cơ bản của Ollama:

LệnhChức năng

ollama run <tên_mô_hình>Chạy mô hình

ollama pull <tên_mô_hình>Tải mô hình về máy

ollama listXem danh sách các mô hình đã tải

ollama rm <tên_mô_hình>Xóa mô hình khỏi máy

ollama create <model>Tạo mô hình tùy chỉnh từ Modelfile

ollama serverChạy server Ollama để tích hợp qua API

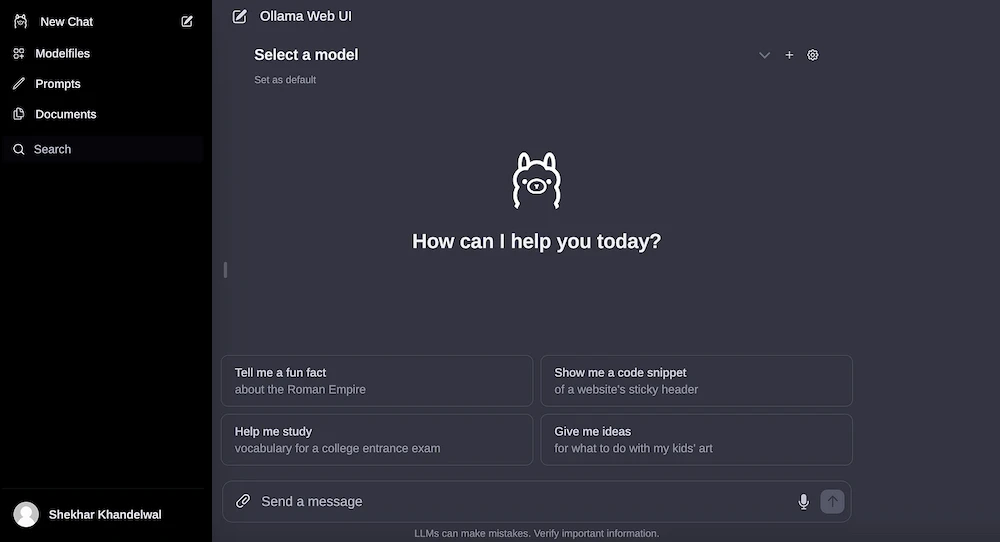

Ngoài CLI và API, cộng đồng Ollama cũng đã phát triển nhiều giao diện người dùng web (WebUI) thân thiện, giúp việc tương tác với Ollama trở nên dễ dàng hơn cho những người không quen thuộc với dòng lệnh. Một trong những WebUI phổ biến là Open WebUI (trước đây là Ollama WebUI):

Bạn có thể cài đặt Open WebUI thông qua Docker hoặc các phương pháp khác được hướng dẫn trên trang GitHub của dự án. Sau khi cài đặt, Open WebUI sẽ cung cấp một giao diện giống như ChatGPT, nơi bạn có thể chọn mô hình, nhập câu hỏi và xem phản hồi một cách trực quan.

Với khả năng chạy ngoại tuyến, bảo mật dữ liệu và chi phí miễn phí, Ollama là lựa chọn lý tưởng cho nhà phát triển, nhà nghiên cứu và doanh nghiệp nhỏ. Hãy thử cài đặt và khám phá Ollama AI ngay hôm nay để trải nghiệm sức mạnh của AI cục bộ!

Với khả năng chạy ngoại tuyến, bảo mật dữ liệu và chi phí miễn phí, Ollama là lựa chọn lý tưởng cho nhà phát triển, nhà nghiên cứu và doanh nghiệp nhỏ. Hãy thử cài đặt và khám phá Ollama AI ngay hôm nay để trải nghiệm sức mạnh của AI cục bộ!

Link bài viết: https://tino.vn/blog/ollama-ai-la-gi/ Nguồn:tinhte.vn/thread/ollama-ai-la-gi-huong-dan-cach-dang-ky-va-su-dung-ollama-ai-2025.4043224/